Los ordenadores, que se convirtieron en parte inseparable de nuestras vidas hace unas ocho décadas, se han hecho más rápidos y pequeños, pero su arquitectura básica no ha cambiado. Sigue habiendo una parte que almacena la información: la memoria (RAM o memoria de acceso aleatorio, y el disco duro). Otra parte, la CPU o unidad central de procesamiento, procesa la información.

Pero ahora, el Profesor Asociado Shahar Kvatinsky, del Instituto Tecnológico Technion-Israel de Haifa, presenta una alternativa estructural. Ha unido las funciones de “pensar” y “recordar” en una sola unidad, ha construido una red neuronal en el hardware de un chip y, como prueba de concepto, le ha enseñado a reconocer letras manuscritas. Los resultados de su estudio se han publicado recientemente en la prestigiosa revista Nature Electronics con el título “A memristive deep belief neural network based on silicon synapses”.

“Nos gusta describir un ordenador como un ‘cerebro’, pero un hardware totalmente separado para almacenar información y para utilizarla no es como funciona un cerebro orgánico”, explica Kvatinsky, que es miembro de la Facultad Viterbi de Ingeniería Eléctrica e Informática del Technion. Desarrolla hardware neuromórfico, circuitos electrónicos inspirados en arquitecturas neurobiológicas presentes en el sistema nervioso. La idea de este tipo de ordenadores se desarrolló por primera vez en los años 80 en el Instituto Tecnológico de California, pero la evolución tecnológica moderna ha permitido avances considerables en este campo desde entonces.

¿Están los ordenadores modernos superando al cerebro humano?

Se podría pensar que los ordenadores modernos ya están superando al cerebro humano, puesto que un ordenador ya ha derrotado a los mejores jugadores humanos de ajedrez y Go. Aunque la respuesta es “sí”, AlphaGo, el programa que derrotó a múltiples maestros de Go, dependía de 1.500 procesadores y costaba 3.000 dólares de electricidad por partida. El consumo de energía de los jugadores humanos para la misma partida ascendía a un bocadillo, más o menos, y ese mismo jugador también es capaz de hablar, conducir y realizar otras innumerables funcionalidades. A los ordenadores aún les queda mucho camino por recorrer.

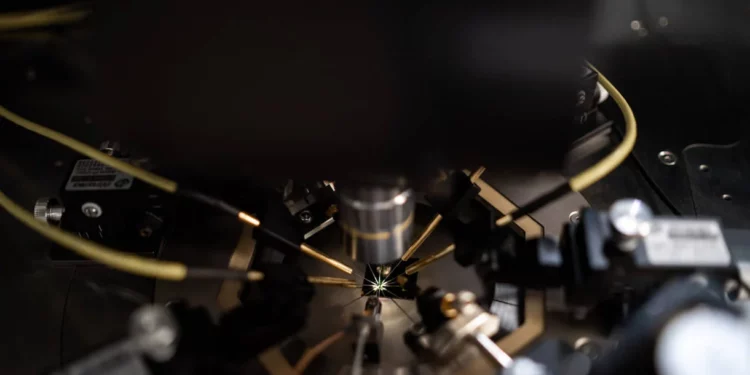

En colaboración con Tower Semiconductor -el principal productor mundial de soluciones de semiconductores analógicos de alto valor que suministra en circuitos integrados analógicos a más de 300 clientes de todo el mundo en los sectores de automoción, medicina, industria, consumo, aeroespacial y defensa, entre otros-, Kvatinsky y su equipo diseñaron y construyeron un chip informático que, como un cerebro orgánico, lo hace todo. Almacena la información y la procesa. Este chip también es sólo hardware, lo que significa que su programación no está separada, sino integrada en el chip.

Lo que hace este chip es aprender: en concreto, aprender a reconocer la escritura a mano, una proeza lograda mediante algoritmos de creencia profunda. A diferencia de la mayoría de los chips neuromórficos investigados en la actualidad, que utilizan tecnologías emergentes no convencionales, éste se basa en tecnología comercial fabricada por Tower Semiconductor.

Al presentarle múltiples ejemplos manuscritos de cada letra, el chip aprendió cuál es cuál y logró un 97% de precisión en el reconocimiento con un consumo de energía extremadamente bajo.

Las redes neuronales artificiales aprenden de forma similar a los cerebros vivos. Se les presentan ejemplos (ejemplos de letras escritas a mano, en este estudio concreto) y “descubren” por sí solas los elementos que hacen que una letra sea diferente de las demás pero similar a la misma letra en otra escritura. Cuando la red neuronal se implementa como hardware, el proceso de aprendizaje refuerza la conductividad de algunos nodos. Esto es muy parecido a cómo, cuando aprendemos, se refuerzan las conexiones entre las neuronas de nuestro cerebro.

Hay innumerables usos potenciales para los chips que lo hacen todo. Por ejemplo, sugiere Kvatinsky, un chip de este tipo podría incorporarse al sensor de la cámara de los smartphones y dispositivos similares, eliminando la conversión de datos analógicos en digitales, un paso que todos estos dispositivos realizan antes de aplicar cualquier forma de mejora a la imagen. En su lugar, todo el procesamiento podría realizarse directamente sobre la imagen en bruto antes de almacenarla en un formato digital comprimido.

“Las empresas comerciales están en una carrera constante por mejorar su producto”, explica Kvatinsky. “No pueden permitirse volver a la mesa de dibujo y reimaginar el producto desde cero. Esa es una ventaja que tiene el mundo académico: podemos desarrollar un nuevo concepto que creemos que podría ser mejor y, lanzarlo cuando pueda competir con lo que ya está en el mercado”.

Este estudio fue dirigido por dos investigadores del laboratorio de Kvatinsky. El Dr. Wei Wang, becario posdoctoral que ahora dirige su propio grupo de investigación en Shenzhen (China), concibió los conceptos teóricos de la red de creencia profunda basada en hardware y realizó las mediciones experimentales, mientras que el estudiante de doctorado Loai Danial, que ya ha terminado sus estudios de doctorado y trabaja en Mobileye, diseñó el chip físico y dirigió los pasos necesarios para su fabricación. El trabajo ha contado con el apoyo del Consejo Europeo de Investigación (ERC) y del programa Horizonte 2020 Tecnologías Futuras y Emergentes (FET)-OPEN de la UE.